除非是保險精算師或華爾街的量化分析師,不然大部份的人對於演算法以及它的運作方式都只有一個模糊的概念。但實際上它對我們的日常生活有著相當大的影響。演算法是一組指令,下指令能夠讓電腦幫助我們解決問題。隱藏在大數據之中演算法可以推薦你在Pandora找到適合的音樂,在LinkedIn找到工作或在Match.com找到生命中的真愛。

這些數學模型被認為是中立的。但是觀察演算法多年的前華爾街定量分析師Cathy O’Neil,卻有完全相反的看法。在她的書《毀壞性的數學武器:大數據如何威脅民主社會並造成不平等( Weapons of Math Destruction: How Big Data Increases Inequality and Threatens Democracy)》中, O’Neil說,即使這些大規模殺傷性武器的出發點是善意的,但最終導致的結果卻將傷害到窮人和少數族裔,並成為“隨意揮舞的秘密逞罰“。

模型和直覺

演算法不再只是”破壞式的數學武器”,它廣泛地使用在世界各地的數學模型,有些能夠健全發展,為人們帶來好處;但有些卻朝不好的地方發展。世界上無論是數學或從其他方式構建的模型,都是從直覺開始,這是一種對表面下的事物具備更深層次邏輯感知的本能。人類與生俱來的本能,可能會產生偏見和錯誤的假設。但可以肯定的是,直覺或論文都是科學的方法。檢查時,使用直覺是一種非常有效的方法,而機械化的方式則可以測試人的直覺,有必要的話可以做出修正。

O’Neil引用新生代的棒球數據(Michael Lewis的著作 : 《魔球—逆境中致勝的智慧》),來舉例說明。在這本書的開頭,奧克蘭運動家隊球隊經理Billy Beane直覺地認為使用性能指標,如打點數據 (RBIs) 是被高估的評斷方式,而其他較不明顯的衡量數據(如上壘率)反而能更好的預測整體成功機率。統計者Bill James開始蒐集並整合Beane判斷球員去留的數據。

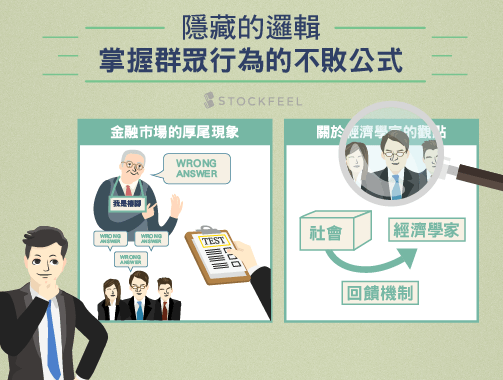

雖然體育愛好者對於這個議題仍有正反兩極的看法,但這個評估運動員的方法除了在棒球界相當地盛行之外,也受到了其它運動的青睞。O’Neil說,魔球故事中的模型會成功有幾個簡單的原因。首先,它較為透明:任何有基本數理能力的人都可以理解輸入和輸出的數據。其次,它的目標是明確的,並適當的進行量化。第三,有一個自我修正的反饋機制:新的輸入數據和輸出數據可以使該模型不斷的精進。

作者認為如果缺乏這三個的演算要素,使得運算不透明、目標或許不適合被量化 、回饋無限迴圈,無法自我修正,甚至只會強化錯誤的假設,往往很有可能會出錯。

華爾街的炸彈

O’Neil在哈佛大學獲得數學博士學位,爾後在巴納德學院任教後,得到了在對沖基金DE Shaw的工作機會。起初,她欣然接受從學術界轉行的所產生的變化,並認為對沖基金在金融體系中怎麼說也是“道德中立的拾荒者”,對沖基金沒有創造複雜的衍生金融產品(如:房貸抵押債券(Mortgage-backed Securities,MBS))的市場,這些商品是造成金融危機的重要角色。對沖基金只是“會操弄這些商品”罷了。

但隨著次貸危機的蔓延,最終延燒到擁有D.E. Shaw 20%的股份雷曼兄弟,內部對於對沖基金的情緒變得焦躁。各界對於這樣可能前所未有卻又迫在眉睫的危機充滿了憂慮,那些所謂的數學模型無法給出一個合理的解釋。她最終與其他人一樣意識到,數學是問題的核心。

用於評估MBS風險的最新演算法變成了煙霧彈。他們的“數學”設計隱蔽了真實的風險水平。這些數學模型不僅不夠透明,也缺乏一個健全的回饋機制。重要的是,評估這些風險的人正是收取販售這些金融商品公司費用的人。正是這樣的模型塑造出了華爾街的炸彈

夢想破滅後,O’Neil離開了Shaw,在2009年進入RiskMetrics Group公司,它提供銀行和其他金融服務公司的風險分析。但她覺得那些像她一樣提出風險警告的人們的意見總是被放在最後面。幾年後,她在一個名為Intent Media的新創公司擔任數據科學家,專門分析網路流量和設計演算法,幫助線上公司完全發揮電子商務的優勢。 O’Neil 在使用金融和大數據的演算法之中看到了令人不安的相似之處。

複雜的數學模型缺乏真正的自我修正能力,市場的需求造就了這些模型。如果一個模式能夠達到最大化的利潤,就表示這是正確的。“否則,為什麼這個模式能得到市場的獎勵呢?”。但市場對於數學模式的依賴造成了2008年華爾街災難性的結果,缺少了一定的分析去確保模型運算的公平性和真實性,“數學模型的濫用”只會默默地加快災難發生的速度。O’Neil離開了公司,開始致力於幫客戶執行這樣的分析。

教育層面的不幸遭遇

在2002年《不放棄任何孩子(No Child Left Behind Act,NCLB)》法案提出之後,擴大了標準化考試制度的使用範圍,因此出現了分析這些考試數據的市場。試圖使用這些數據找出“表現不佳”的教師。然而,用心良苦的O’Neil發現這些模型的科學標準並沒有用,反而讓許多優秀教師受害,並且對推動教育事業沒有任何幫助。

2009年,華盛頓D.C的學校系統實施一種稱為IMPACT的教師評估工具。IMPACT使用複雜的演算法去測量學生的進步,並試圖去分辨個別教師的教學造成他們的進步(或退步)的原因。即使父母和校長對這些教師有很好的評價,但是最低分的教師還是會被解僱。

O’Neil檢查了和這項績效方法類似的評估方式。發現有一位資深的老師在這項滿分為100分的測試當中,只得到了6分,但是隔年卻回升至96分,除此之外,也有一個重要的發現:連續兩年任教同一科目的教師,每四位就有一位兩年的分數差距超過40分。

這些評估模型缺乏透明度,O’Neil寫道,他們“武斷、不公正而且對於他人的意見視若無暏”。然而,像Google這種樣本數量多、能不斷獲取統計回饋的公司,就能夠立即發現和糾正錯誤。但像是教師評價系統僅基於幾十個學生每年考試的結果,就會很容易做出輕率的判斷。此外,也沒有辦法評估系統的錯誤。如果一個好老師因為統計的數據而被錯誤解僱,緊接著成為另一所學校的好老師,這樣的“數據”就不會被計算到。

工作上的數據分析

教師絕非唯一的案例。面對緩慢的成長,公司會試圖在各方面改進。由於人事決策是一家公司最重要的決定,“人力資源管理”已成為一筆大生意。一些系統已經有能力挑選有潛力員工,並能夠過濾掉“靠猜測應徵工作”的人。這些系統運用性格測試去實現自動化招聘的過程。諮詢公司德勤(Deloitte)估計,在美國,這項測試用於60%到70%的潛在員工,比五年前增加了近一倍。

在性格測試的廣泛流行下,也出現了與其背道而馳的研究,這項研究認為這並不是用來預測未來工作表現的一個很好的指標。這些招聘系統產生的數據會在演算法精確計算後會讓人產生一些錯覺,誤以為這是很有效率的招募過程。但O’Neil表示,這些程序缺乏透明度,而且被拒絕的員工很少知道他們為什麼不適合。這種招聘過程也缺乏一個良好的回饋機制,也就是未能識別錯誤和使用這些錯誤去改良系統。.

越來越多人在工作之中,受到大數據的影響,像是各種排程軟體的影響。只要是持續不斷的數據,都可以使用這樣的軟體,例如星巴克(Starbucks, SBUX-US)可以用來改善人員的配置。《紐約時報(New York Times)》曾報導一個身為咖啡師,半工半讀完成學業的單親婦女,探索新科技如何製造混亂,而這為低薪工作者,又會帶來什麼樣的影響。根據美國政府公佈的數據,從事餐飲業的工作人員,約有三分之二常常會在短期之內收到調度通知。

O’Neil說這種不穩定性可能產生深遠和負面的影響。雜亂無章的調度可能讓教師難以留在學校,或使得弱勢工人在供過於求的低工資的勞動力資源中持續存在。O’Neil說“這個軟體就像是被設計來懲罰低工資工人,並打壓他們。”而混亂的時間表對下一代的連鎖反應也一樣。“年輕的孩子和家長都要面對不可預知的工作時程”經濟政策研究所發現,這“更可能造成較差的認知和行為結果。”

《時代雜誌》中揭露,國會中曾打算立法約束排程軟體,但並沒有繼續執行。

犯罪與刑責

在美國,24州的法院了解到了刑事司法系統當中無意識偏見(unconscious bias)的重要性,他們認為使用演算模型能夠幫助法官在量刑程序中評估再犯的風險。O’Neil表示,對於某些評估措施來說,這項系統已經是一種進步。但是,試圖透過量化和明確的定意來確認是什麼原因導致真實社會的混亂,反而會創造新的問題。

一個目前流行的評量包括一個冗長的調查問卷,旨在找出相關再犯的危險因素。可能會問到過去相關的警調事件;並且研究年輕黑人男性被警察攔下的頻率,即使它一開始的意圖是想要減少偏見,但是這可能演變成種族問題。O’Neil指出,其他問題如受訪者的朋友或親戚是否有犯罪記錄,會在審判中使辯護律師提出異議。但適當的審查可以避免產生一些複雜的風險模型不透明的情況。

另一個趨勢是利用犯罪預測軟件去預測犯罪模式,並相應地調整警察部屬。作者認為這個類型的潛在問題是他們基本上需要大量的數據,造成數據的良莠不齊。在執行犯罪預測軟體後,即使規定的首要任務是防止暴力和嚴重犯罪,但是少部份的干擾數據可能會被放大,使系統產生偏差。“一旦干擾數據流入預測模型,會有更多的警察被吸引到那些地方,他們會誤以為在那裡有可能逮捕更多的人。”因此而增加的逮捕行動似乎應該優先處理,因為它會進而反應到在判決中所使用的累犯模型,O’Neil形容這是一種破壞和“惡性的回饋循環”。

信用評級的危機

寬鬆的信貸,使得金融危機加劇,因此銀行設法讓他們的風險評估更加嚴格。O’Neil指出,早期的風險評估演算法-著名的FICO評分,也不是沒有問題的,但O’Neil認為在大多數情況下,它仍是一個健全的數學模型。因為它較為透明、有規律,而且有一個清晰明瞭的回饋循環。如果違約率不如模型預期,徵信機構可以進行調整。

然而近年來,新型的偽科學評分方式猖獗地成長。“我們在任何一個可以想像得到的層面隨意地添加那些從統計學家和數學家集結而來的數據,從我們的郵政編碼、網路搜尋的模式到我們的消費模式。” 無數的公司使用集結這些數據形成的“電子評分(e-scoures)”來確定我們的信用分數。然而,與FICO評分相較,它是“隨心所欲、不負責任、毫無規範、不公平的。”

信用評級和電子評分中的各種應用當中,已經出現了一個巨大的“數據市集”,不管是在侵略性廣告或人資招聘都能看到它的存在。作者認為在無盡的數據之中,合法的、似是而非的評量措施之間的界限變得更加地模糊。正如一位新創企業家在網站上的聲明,“所有的數據都是信評數據。”

這些只是這個大型程序之中的一部分,美國消費者聯盟表示 : “評估我們的,是一些秘密的方程式,其中有一些資訊甚至被錯誤的讀取。”電子評分和其他的數據是用來把消費者分類為“更微小的群體”,並針對弱勢群體的保險和其他金融產品擬定侵略性的價格。

而企業獲取GPS等行動數據的可能性只會加倍成長。由於保險公司和其他公司“藉由審視我們的生活,將我們歸類到不同的類型。但它不會基於傳統指標如年齡、性別、收入或郵政編碼,而是由幾乎全部是機器生成的行為模式來歸納新的分類方式“。

大數據的改革

在 O’Neil的結論中,她認為我們需要“缷下”這種毀滅性的數學武器,第一步是進行“演算法審查”,揭露這些數學模型的黑盒子。它們是不透明、無堅不催,並時常保護知識財產權的系統模型。

為實現這樣的目標,普林斯頓大學已經推出網站透明度和責任項目(Web Transparency and Accountability Project)。卡耐基梅隆(Carnegie Mellon)大學和麻省理工學院(MIT)也是類似計畫的中樞。最後O’Neil寫道,我們必須認識到這些數學模型已經滲入到了我們的生活每一個層面,這不只是數據,而是來自我們做出哪些系統會注意到的選擇……這些選擇並不僅只是運算,利潤和效率。他們也是道德的根本。“

《K@W》授權轉載