進入 2023 年以來,科技界里仿佛沒有了大事,只剩下了人工智慧。人人都在談論 ChatGPT、科技圈開卷大模型、OpenAI 估值節節攀升、大公司你追我趕,硝煙四起……

人工智慧三巨頭是誰?

而這一切繁榮的背後,其實都離不開三位人工智慧研究者的工作———曾因提出和發展深度學習神經網路,在 2019 年獲得電腦界最高榮譽「圖靈獎」的 Geoffrey Hinton、Yoshua Bengio、Yann LeCun。

可以說,沒有這三位學者的研究,我們今天根本看不到 ChatGPT、Bard 的出現,也不會這麽快的就能在日常生活中使用語音識別、人臉識別、圖片檢索、機器翻譯、自動駕駛等技術。

人工智慧教父是誰?

其中,Geoffrey Hinton 是「三巨頭」中最核心的人物,被業界譽為「人工智慧教父」。他在 2013 年加入 Google,把深度學習技術帶進了 Google 的多項業務,直接推動 Google 成為了 AI 技術最出色的公司之一。同時,他還親自培養了一大批機器學習相關的人才,包括了如今 OpenAI 的聯合創辦人和首席科學家 Ilya Sutskever。

「深度學習三大先驅」,圖片來自於推特(Twitter, TWTR-US)

「深度學習三大先驅」,圖片來自於推特(Twitter, TWTR-US)

Geoffrey Hinton 為什麼離職?

而就在加入 Google 的第十年、深度學習迎來爆發式發展的當下,幾週前,現年 75 歲的 Geoffrey Hinton 辭去了他在 Google 的工作。而離職的原因,用他的原話來講,是想要沒有任何負擔的給所有人講一些他關於人工智慧發展的「真心話」。

人工智慧教父的警告

人工智慧教父的默默耕耘

如果說誰最熱愛深度學習相關的人工智慧研究,Geoffrey Hinton 一定是最有發言權的那一位。從上個世紀 70 年代至今,Geoffrey Hinton 作為電腦神經網路的開拓者,已經在這個領域默默耕耘了近 50 年。

對於 Geoffrey Hinton 來說,從無到有的創造一個全新概念和技術的過程曾經無比艱難。

從上個世紀 80 年代他提出神經網路理論開始,一直到本世紀初,長達 20 多年的時間里,學術界對神經網路理論都充滿質疑,同時,受制於當時數據集規模限制以及電腦算力的不足,相關研究的進展也一度非常緩慢。在這個漫長的過程中,一些人放棄了、一些人轉了研究方向,但 Geoffrey Hinton 從未放棄過關於深度學習神經網路的研究。

但如今,深度學習終於守得雲開見月明,所有人都開始向深度學習里瘋狂砸人力、砸資金,堅守了多年的 Geoffrey Hinton 這時卻想要大家都暫停腳步,甚至對自己付出了一生心血的研究感到有些後悔,為什麼?

在最近接受紐約時報的專訪中,Geoffrey Hinton 表示,自己此次從 Google 離職並不是因為要批判 Google,而是他能夠在不影響 Google 的情況下,去真實地談論 AI 的潛在風險。

無止盡的競爭

在他看來,作為 AI 技術的領軍者,過去這些年 Google 一直扮演著一位「負責任的管家」的角色,小心翼翼地保留和控制著那些可能造成傷害的技術。但由於微軟(Microsoft, MSFT-US)極快地將 Bing 和 ChatGPT 結合併向大眾發布,挑戰了 Google 核心的搜尋引擎的業務,所以 Google也無法像過去那樣繼續保持著發展節奏,科技巨頭陷入了一場可能無法停止的競爭之中。

In the NYT today, Cade Metz implies that I left Google so that I could criticize Google. Actually, I left so that I could talk about the dangers of AI without considering how this impacts Google. Google has acted very responsibly.

— Geoffrey Hinton (@geoffreyhinton) May 1, 2023

Hinton 的擔憂

在這樣的情況下,他需要以一名研究者而不是 Google 員工的身份站出來,給大家發出警告。結合整個採訪來看,Hinton 主要有以下幾個方面的擔憂。

一是在人工智慧技術的支持下,他認為網路將很快被各種虛假資訊淹沒。這些資訊包括文字、照片、影片等,而普通人將越來越難分辨這些資訊的真假,引發社會的失序。

二是就業市場可能在還沒有準備好的情況下被顛覆,造成失業潮的爆發。雖然目前像 ChatGPT 這樣的聊天機器人還只是對人類工作的補充,但按照人工智慧的發展速度,它們將很快可以取代律師助理、翻譯、行政助理等其他任何基礎的、重複性的工作。「它消除了苦差事,但帶走的可能遠不止於此。」Hinton 表示。

第三,他還擔心人工智慧技術的接下來的發展會對人類社會構成威脅。他承認,在他們過去的研究之中,人工智慧常常能從大量數據中學習進而產生出很多讓人意想不到的行為。而目前,包括個人和公司在內的很多使用者們不僅讓人工智慧自主產生代碼,也讓人工智慧運作和管理著代碼。在這種不斷的訓練之中,很有可能讓「自主殺手機器人」真的成為現實。

「很多人都覺著這很遙遠,我曾經也是這麽認為的,覺得至少還要有 30 ~ 50 年我們才會走到那一天。但就我目前所了解到的資訊而言,我已經不這麽想了。」Hinton 認為,Google和微軟以及其他大型公司之間的競爭,將很快升級為一場全球性競爭,如果沒有某種監管,這場競爭將不會停止,人工智慧發展的速度會遠超我們的想像,並最終走向失控。

監管 AI 的可行性?

如果以上這些話從別人口中說出來,大家可能仍然會覺得這些觀點帶著危言聳聽的意味。但當如今世界上人工智慧領域最權威的專家、深度學習的奠基人 Geoffrey Hinton 也這麽說時,也引發了更多人開始認真思考和關注這個問題。

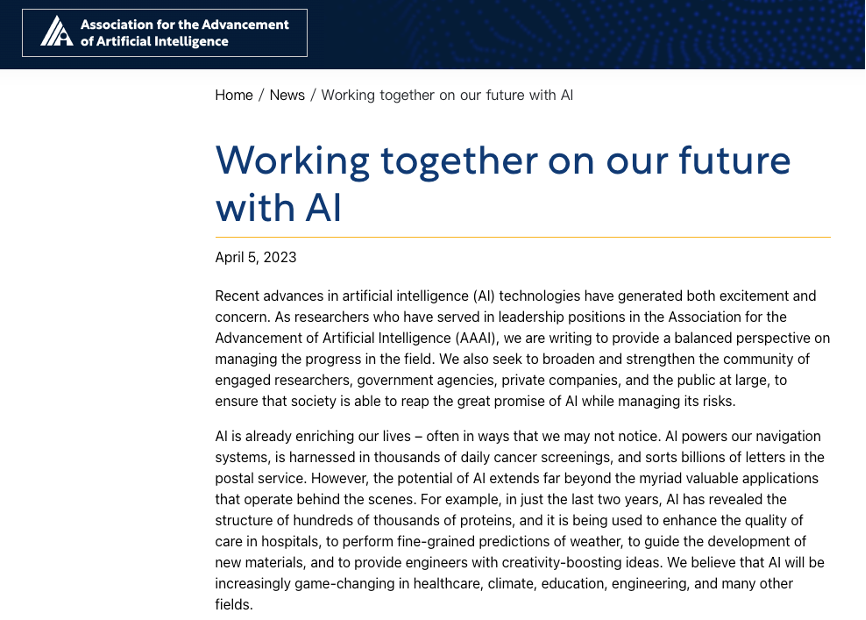

實際上,在此次 Geoffrey Hinton 發聲之前,最近幾個月來人工智慧領域就已經發起過兩波大型的聯名,呼籲謹慎地發展人工智慧技術。

一次是由馬斯克、Yoshua Bengio 等數千名來自學術界和企業界的巨頭呼籲至少暫停 6 個月比GPT- 4 更強模型的研究的公開信。另一次則是由擁有 40 多年歷史、人工智慧領域最權威學術機構之一的人工智慧促進協會(AAAI)的 19 名現任及前任領導人所發布的聯名信,其中也包括了微軟現任首席科學家、人工智慧研究專家 Eric Horvitz。

雖然先前馬斯克他們暫停模型研發的呼籲在業界受到了爭議,包括 Yann LeCun、吳恩達在內的研究者都對停止研發「一刀切」的做法表示了反對,甚至也有人質疑馬斯克等人提出暫停研發是為了私利。但目前看來,關於共同加強 AI 監管、預防潛在性危險發生的觀點,大家的看法幾乎都是一致的。

在今天 Geoffrey Hinton 的報導發出後,吳恩達第一時間轉發了 Geoffrey Hinton 的推特表示支持,感謝 Hinton 對於人工智慧技術所做出的不可估量的貢獻,以及對人工智慧在虛假資訊、自動機器和勞動力影響方面的發聲。

It was a privilege working with you @geoffreyhinton in the early days of Google Brain. Thank you for your immeasurable contributions both to AI technology and for being a sensible voice on the risks of AI, such as misinformation, autonomous weapons and labor disruption. https://t.co/HzeCIRAV1Y

— Andrew Ng (@AndrewYNg) May 1, 2023

一些 AI 的投資人、研究者今天也紛紛轉發了 Geoffrey Hinton 的訪談,呼籲學界、工業界、政府監管機構應該快速行動起來,趁目前技術還在可控範圍內,盡快制定好監管框架和應用方案等。

Every AI capabilities researcher will soon wake up to @geoffreyhinton’s realization and regret their life’s work.

— Liron Shapira (@liron) May 1, 2023

It’s beautiful work, but we weren’t ready for it.

I hope they arrive at their regret state ASAP while there’s still time for a last-ditch policy response. https://t.co/5WJIWMcQKD

當然,也有研究者並不認同 AI 威脅論,其中就包括了 Geoffrey Hinton 曾經的學生、研究的夥伴 Yann LeCun。他先前多次表示,大語言模型根本不算什麼,要想真正通往 AGI 之路,還需要構建「世界模型」。

對此,很多人也很希望這些對於人工智慧發展持有不同觀點的研究泰斗們能夠很快來一場深度對談,讓人們更多地了解目前人工智慧發展前方的機遇和風險。

Would love to watch a debate on AI Risk between @ylecun and @geoffreyhinton, who should moderate, @lexfridman?

— Dr. Roman Yampolskiy (@romanyam) May 1, 2023

AI 有可能成為核武器?

在此次的訪談中,一個尤其引人關注的地方在於 Geoffrey Hinton 在談到 AI 風險時,多次提及了核武器。從一定程度上來看,Geoffrey Hinton 或許認為 AI 對人類社會的潛在危險並不亞於核武器。

他表示,跟核武器研究不同,現在 AI 研究更危險的地方在於,我們目前幾乎沒有辦法知道有哪些組織或者國家正在秘密研究這項技術。理想的情況下,全球各國組織和科學家們應該共同進行合作和對技術進行控制,但顯然現在很難做到這一點。

作為深度學習技術的發起人,Geoffrey Hinton 坦言自己目前甚至有些後悔進行了這項技術的研究。當潘多拉魔盒被打開,作為研究人員很難去防止不好的人利用這些技術去做不好的事。

而 Hinton 的這種說法也讓人不由地想起了當年「原子彈之父」羅伯特·奧本海默相似的心路歷程。當年,美國在廣島長崎投放原子彈兩個月之後,奧本海默辭去了職務,之後他在擔任美國原子能委員會顧問期間一直致力於遊說國際機構對軍備進行管制,並運用影響力宣揚控制核武器和核不擴散運動。

Geoffrey Hinton 說,以前人們問他如何從事具有潛在危險的技術時,他總會引用奧本海默的話:「當你看到一個東西擁有美妙的技術前景時,就儘管去做吧。」但現在,他已經不會再那樣說了。

「人們不應該快速擴大 AI 研究的規模,直到足夠了解自己是否能夠控制它」Geoffrey Hinton 說道。

《虎嗅網》授權轉載

【延伸閱讀】

打破CEO神話-四項成功領導者的關鍵特質_-.png)